Veröffentlichung von DeepSeek-R1T-Chimera

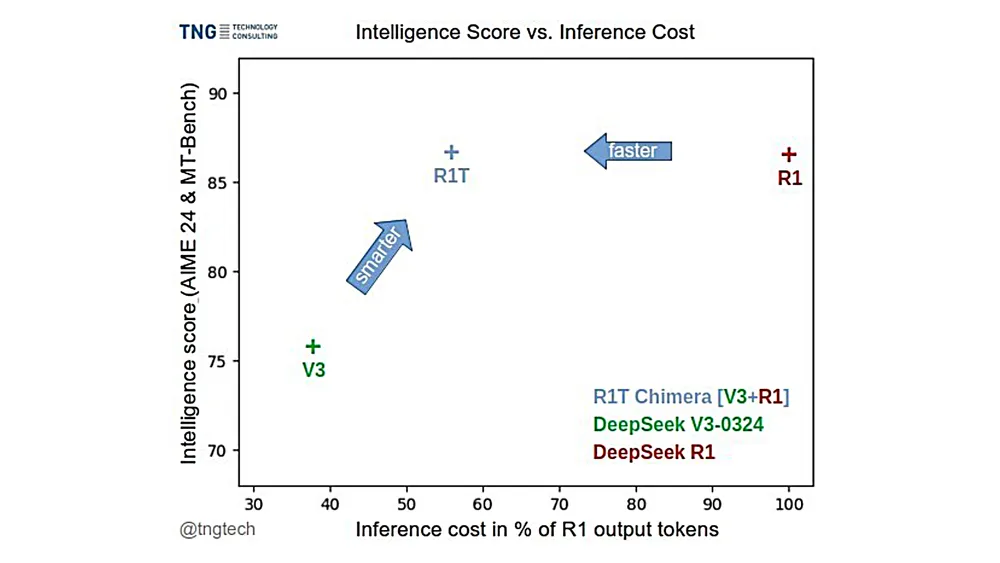

2. Mai 2025Am Wochenende haben wir DeepSeek-R1T-Chimera veröffentlicht. Dabei handelt es sich um ein Open-Weights-Modell, das die Reasoning-Fähigkeiten von R1 zu DeepSeek AI V3-0324 hinzufügt. In Benchmarks scheint es genauso intelligent zu sein wie R1, aber viel schneller, da es 40 Prozent weniger Output-Token verwendet.

Wir haben eine innovative Methode angewendet: Das Chimera ist ein Tochter-LLM, das die Shared Experts von V3 verwendet und um eine individuelle Kombination aus den Routed Experts von R1 ergänzt wurde. Es ist somit kein Feintuning und keine Destillation, sondern ein Modell, das aus Teilen der neuronalen Netze der beiden ursprünglichen MoE-Modelle konstruiert wurde.

Überraschenderweise haben wir bei unseren Experimenten keine Mängel im hybriden Tochtermodell festgestellt. Stattdessen scheinen seine Argumentations- und Denkprozesse kompakter und geordneter zu sein als die manchmal sehr langen und umständlichen Gedanken des ursprünglichen R1-Modells.

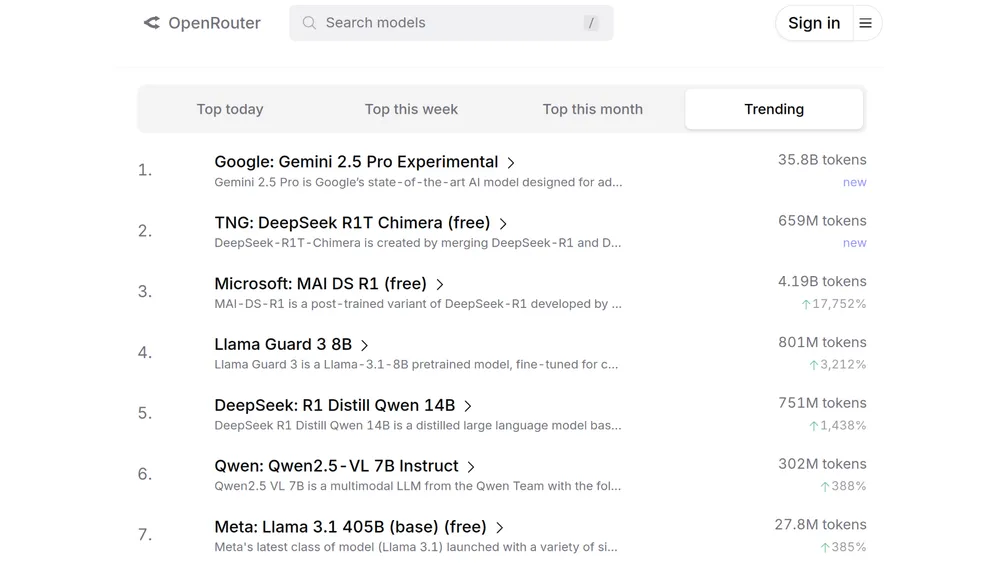

Unser kombiniertes Modell hat in der Community einiges an Aufmerksamkeit erregt. Es wurde von OpenRouter übernommen und gehostet. Dort war es in der Liste der aktuell beliebtesten Modelle vorübergehend auf Platz 2 zu finden, mit bereits über einer Milliarde verarbeiteten Tokens.

Sie können das kombinierte Modell selbst ausprobieren.

Die Model Weights sind auf Hugging Face.

Wir bedanken uns bei DeepSeek für das Bereitstellen der ursprünglichen Modelle V3 und R1, die diese Forschung ermöglichen.