Veröffentlichung von DeepSeek-TNG R1T2 Chimera

3. Juli 2025

Heute veröffentlichen wir DeepSeek-TNG R1T2 Chimera.

Das neue Chimera ist ein Tri-Mind Assembly-of-Experts Large Language Model mit drei Elternmodellen: DeepSeek R1-0528, R1 und V3-0324.

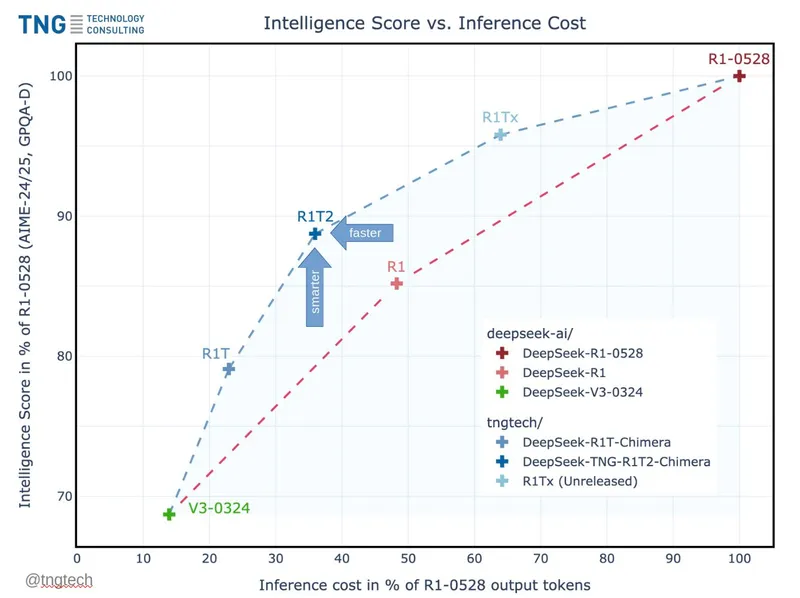

R1T2 bewegt sich in einem optimalen Verhältnis zwischen Intelligenz und Inferenzkosten. Es scheint, als sei R1T2

etwa 20% schneller als R1 und mehr als doppelt so schnell wie R1-0528,

in Benchmarks wie GPQA-Diamond und AIME-24/25 deutlich intelligenter als R1, wenn auch nicht ganz auf dem Niveau von R1-0528,

wesentlich intelligenter als unser erstes R1T Chimera,

<think>-token-konsistent, was eine große Verbesserung darstellt.

Unserem Empfinden nach ist das Modell insgesamt freundlich und angenehm im Umgang. Die Model Weights sind unter der MIT-Lizenz auf Hugging Face verfügbar.

Vielen Dank an DeepSeek AI für die Veröffentlichung ihrer Modelle, an Chutes, OpenRouter und Alex Atallah für das Hosting von R1T sowie an die Community für Benchmarking, Tests und die Nutzung unserer Chimera-Modelle.